文 | 追问 nextquestion

机器能否真正拥有意识?认知和计算神经科学教授、萨赛克斯大学塞克勒意识科学及心理中心创始人之一的 Anil Seth,作为意识领域的权威专家,近日在 arxiv 的综述论文中提出,尽管技术进步迅速,但实现具有意识的 AI 还需要满足一系列复杂的现实条件。他着重指出,意识可能与我们作为生物体具有本质关联,并由此反驳了 「只要有足够的算力就能产生意识」 的常见观念。

▷Seth, Anil. "Conscious artificial intelligence and biological naturalism." (2024).

阿尼尔·赛斯 Anil Seth 认知和计算神经科学教授,

萨赛克斯大学塞克勒意识科学及心理中心创始人之一

他发表了 100 多篇科学论文,并为普通大众讲授和撰写有关神经科学的文章,定期为 《新科学家》(New Scientist)、《卫报》(The Guardian) 和英国广播公司 (BBC) 撰稿。他的研究被众多媒体报道,曾接受 BBC、奈飞 (Netflix) 以及美国著名哲学家、神经学家萨姆·哈里斯 (Sam Harris) 的播客采访。他在 2017 年的 TED 演讲已被观看超过 1100 万次,这证明他有着不可思议的能力,可以使复杂的科学变得易懂和有趣。他最新的作品为 《意识机器》。

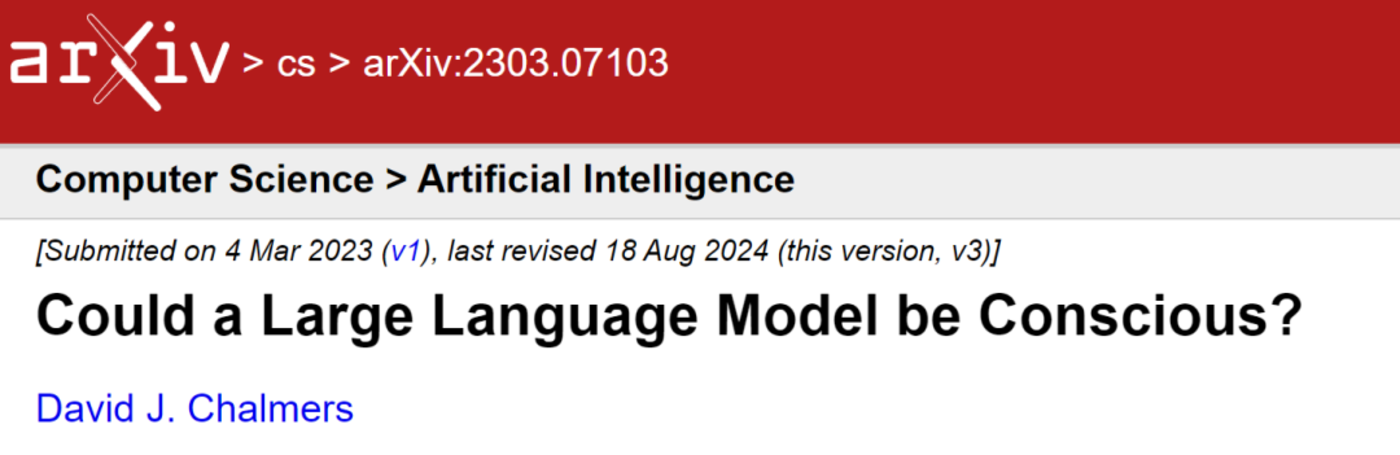

关于人工智能是否具有意识的讨论

随着 AI 系统日益强大,关于 AI 是否具备意识的讨论不断升温,下面先概述之前众多学者对该问题的讨论。「意识的困难问题」 提出者 David J. Chalmers 在 2023 年的论文中提出,尽管目前的 AI 模型面临多项技术障碍,例如缺少递归处理能力、全局工作空间以及整体能动性等,但这些障碍很可能在未来十年左右被克服。Chalmer 认为尽管大语言模型当前可能不具备意识,但我们应该认真考虑,在不远的未来,下一代大型语言模型将可能会具备意识。

▷Chalmers, David J. "Could a large language model be conscious?." arXiv preprint arXiv:2303.07103 (2023).

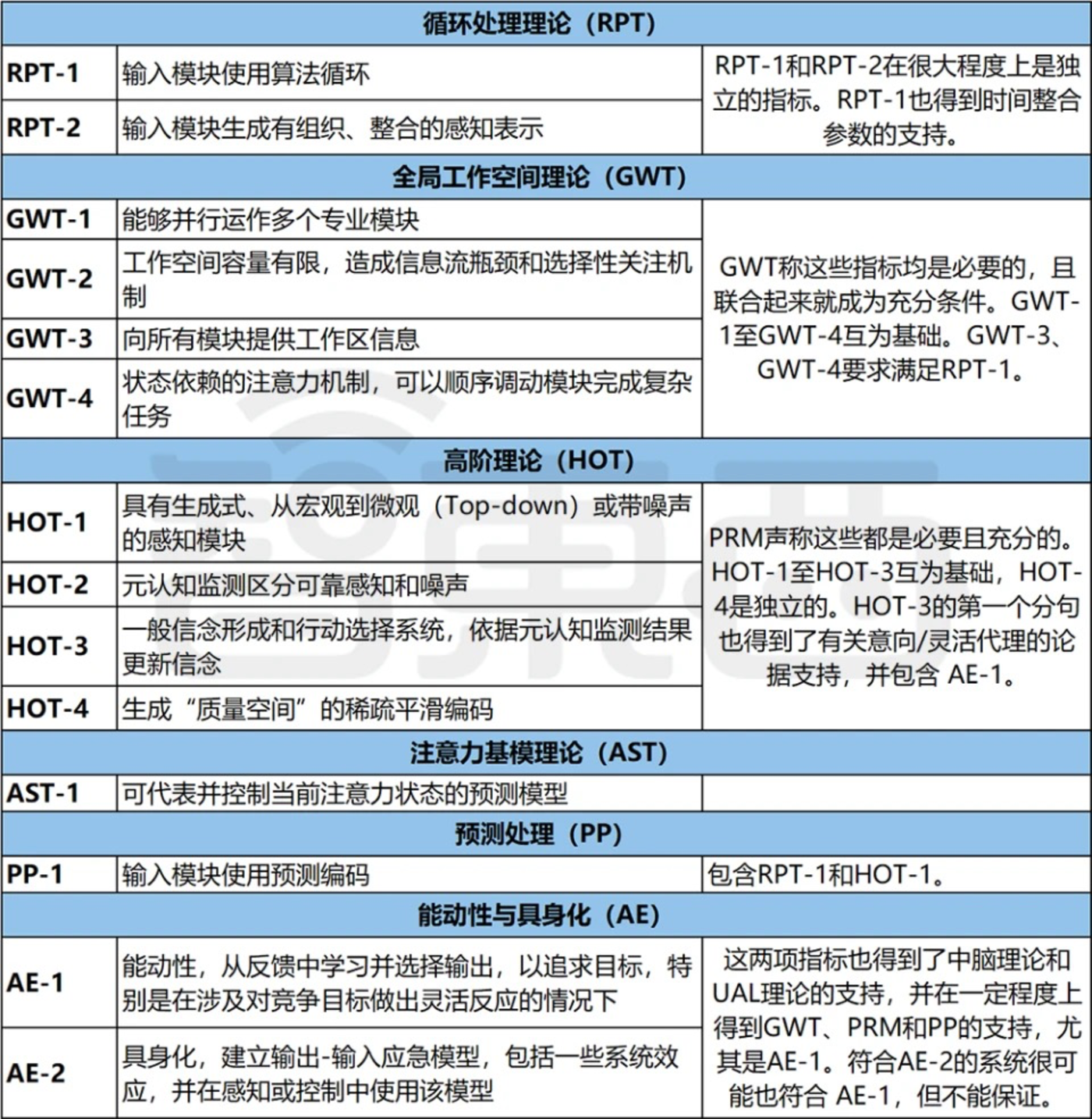

同时,人工智能安全中心 (Center for AI Safety, CAIS) 综合了 Yoshua Bengio 等多位权威人士的讨论,在一份报告中指出,尽管当前的人工智能不具备意识,但许多神经科学理论已提出可行的评估 AI 意识的指标,基于现有技术这些指标是可以实现的。

▷不同意识理论下对于机器是否能具有意识的讨论方向。Butlin, Patrick, et al. "Consciousness in artificial intelligence: insights from the science of consciousness." arXiv preprint arXiv:2308.08708 (2023). 图片:智东西。

但在这场讨论中,一个难点是研究者们往往不自觉地将 AI 人格化。他们认为,由于大模型在逻辑推理和想象力等方面表现出越来越多的 「智慧」,依照雷·库兹韦尔在 《奇点临近》 中的预期,AI 获得人类水平的认知能力似乎指日可待。这种人类中心主义的观点推论认为,如果机器表现出类似人类的行为 (符合某些理论框架下的意识指标),就可能具备意识。然而,这种基于计算功能主义的假设正是 Anil Seth 在其综述文章中所质疑的核心。

支持意识的存在及其物质基础绑定的证据

什么是计算功能主义?让我们先看看著名的忒修斯悖论:如果逐渐更换一艘船上的每一块木板,最终这艘船换尽所有部件后,还能被认为是原来的那艘船吗?换到大脑的背景下,如果将 (有意识) 大脑中的每个模块换成功能上等价的硅基算法,甚至是通过仿真技术完全复制每个神经元之间的连接,那这样的硅基生物,能否被当成最初大脑的等价物,是否仍旧可以被认为是有意识的?这样的假设就被称为计算功能主义,即只要满足给定功能,黑猫白猫都是好猫,意识存在的问题只和是否具有特定计算能力有关。

然而,计算功能主义的批评者指出,当生物组成部分 (神经元) 被非生物 (硅) 部分所替代时,系统在内部运作方式及其整体行为上将不可避免地存在差异。生物学功能是通过复杂的进化过程形成的,积累了大量的相互依存和偶然性,其中部分可能看起来是任意的,但这些特征的合力导致了大脑内部结构中 「一般性且根深蒂固的」 组织原则。这为用硅基替代碳基的可能性施加了许多限制。

具体来看:硅基和碳基的主要差异在于,碳基脑的神经活动会受到代谢限制、电磁场以及其他可能因素的影响。例如,一氧化氮是一种参与许多神经元功能的神经递质,能够自由扩散过细胞膜,这意味着任何硅基的大脑都需要能够检测到这种不断变化物质的位置,而这对于处于离散时间点的模拟是不可行的。

▷Wang, Yaoben, et al. "Sustained release of nitric oxide and cascade generation of reactive nitrogen/oxygen species via an injectable hydrogel for tumor synergistic therapy." Advanced Functional Materials 32.36 (2022): 2206554.

其他例子也能体现硅基与碳基造物的差异。生物神经元的尖峰活动有助于防止有害化学物质如活性氧的积累,这种保护机制是通过神经元特定的放电模式实现的,与其代谢活动紧密相关。新陈代谢直接影响神经系统的通信。然而对于硅基算法,算法本身是不朽的,不需要考虑新陈代谢。算法也无法以百分百的精度,用离散时间点的模拟再现连续变化的神经递质所带来的影响。这意味着人们无法证明当前算法 (如大模型) 可具有意识的基础假设——计算功能主义——是否成立。

将大脑视为动力学系统而非计算工具

以上的证据虽然不足以推翻计算功能主义,但却能够让其显得不那么自圆其说。计算功能主义意味着:机器具有智能的基础是计算功能,与其物理特性无关,基于碳基的计算也适合于硅基。但如果大脑的计算过程与其碳基物理实现密切相关,我们或许有更充分的理由质疑,机器最终也能表现出意识的观点。

我们之所以将大脑看成是计算机,是因为习惯了从大脑的认知功能出发思考问题。然而,随着对大脑内部运行机制的了解深入,神经科学界并没有发现生物脑的 「心智软件」 和 「湿件」 之间,存在类似于计算机硬件和软件之间的明显区别。

大脑活动模式在多个空间和时间尺度上持续展开,不断受到神经递质的扩散、神经网络自身的物理结构以及细胞基础设施的各种属性影响,这些因素都与神经系统代谢活动释放的分子风暴紧密交织在一起。单个神经元本身就是复杂的生物系统,忙于维护自身的完整性并重现其存在所需的物质条件。简单地将大脑视为执行正确计算的机器,忽视了其复杂的多层面生物活动,这种视角既不利于我们深入理解大脑,也会影响我们对意识本质的认识。

另一种观点认为,意识可能仍然依赖于实现功能组织的模式,但不依赖于计算。这种立场被称为非计算功能主义 (non-computational functionalism)。它与大量使用非计算立场的形式主义来理解大脑活动的工作一致,包括认知科学中影响深远的的 「动力学系统」 方法。该方法提供了诸如微分方程的多种数学工具来模拟具身和嵌入式神经系统的属性如何随时间变化。类似的还包括 4E 理论,强调大脑-身体-世界互动的具身、嵌入、执行和扩展方面,以及 Gemma 神经震荡 (30-150Hz) 及同步等。这项研究者都在关注脑的动力学层面。上述观点在重要细节上有所不同,但它们都反对将大脑视为纯粹的计算工具,认为大脑是一个不断变化的动态系统。

将大脑看成动态系统而非计算机,会将我们引入该综述标题中最重要的关键词:生物自然主义(biological naturalism)。这个术语来自 「中文屋」 思想实验的提出者 John Searle,他通过这个思想实验,不仅图灵测试作为判定机器智能存在的充分条件,也反驳了机器可能具备智能的延伸论点。

生物自然主义认为,意识是一种生物现象,源于大脑和身体中的神经以及其他可能的生物过程,是只有生物系统才具有的属性。就如同对天气系统的模拟再准确,也无法在模拟中产生被风吹雨淋的体验,且模拟内部不会变湿。那有证据和理论能佐证生物自然主义吗?下一节将从预测和控制的神经科学视角对生物自然主义加以论证。

预测和控制视角下的生物自然主义

预测性编码理论将大脑的感知、决策与行动看成是最小化预测误差的过程。而大脑之所以要不断更新对外界环境的预测,是为了保持其所属身体的内稳定。对于意识问题,预测性编码的核心主张是,意识内容是大脑 「最佳猜测」 的产物——是自上而下的感知预测对多感官产生的内容整合。上述观点更形象的描述是 「意识是一种控制性幻觉」 ,关键词 「控制性」 强调意识的内容是主动生成的,而不是由外界体验被动赋予的。而意识产生的基础是具有一个能够像生命一样保持内稳态并自复制的身体,这就是生物自然主义的依据之一。

在此基础上外延,对内部身体和自身所处世界的意识感知同样是主动生成,而不是被动赋予。这些与身体相关的感知可能构成了 「自我」 体验的基本部分,而意识本身就既包含体察外物,更包含内观自省,这里的自省,在日常语境中被称为情感。根据预测性编码,情感是基于当前自我状态的一种自上而下的最优估计,这种估计的目标是最小化预测误差。然而如没有生物体存在,也就无所谓自省和对自身状态的预测,因此也就无法产生意识。而对外部世界的感知,更多关注的是控制而非发现。由此可进一步指出,意识是和生物体维持自身存在 (短期自稳定及长期自生成) 且强绑定的特征。

然而,无论当前的机器人或是大模型,都无法做到自复制。一台计算机仅仅能够接收输入并生成输出,而不能生产自己。而对于正在进行自复制系统,由于它们通过一个过程网络不断地再生自己的物质组成部分,并且这个过程网络积极地维持系统与周围环境的界限,因而真的没有办法将它们是什么与它们做什么分开。对于自我复制系统来说,它们通过一个复杂的过程网络不断地重建自己的物质成分,并积极维持与环境的界限,使得这些系统的物质构成与其功能表现不可分割。

对于生物体来说,维持自身的内稳态是生存的必须,即使是最简单的细胞也需要与外界进行物质交换。从生物自然主义的视角看,这种交换是意识形成的先决条件。此外,生物是自复制系统的典型例子:不仅仅能实现预期功能,还能不断地重建自己的物质基础 (自我生产),维持自身的完整性 (自我识别)。因此,生物所具有的意识也与生物本身的物质存在 「利益相关」(skin in the game)。意识不断地参与跨多个组织层次的自我维护过程。

在这种观点下,(更高层级的) 预测处理机制与它们的 (更低层级的) 生物学背景被不可分割地嵌入到同一个整体中,这种嵌入对于实现更高层级的特征 (例如感官整合,全局处理) 以及解释这项特征与意识的关系是必要的。因此,意识与活生生的生命系统密切相关,这不仅限于我们熟知的碳基生命,甚至硅基的人工生命及 Hinton 提出的凡人计算,在生物自然主义的框架下也可能产生意识。

依据自由能原理判断机器意识的存在

英国神经科学家 Karl Friston 的自由能原理,提供了一个独特的视角来解释意识的生物学基础。该原理表明:如果一个系统可以与其外部环境区分开,那么它的内部和外部状态必须是条件独立的。在这种视角下,生物体的存在可以被描述为一种复杂的信息处理过程,目的是最小化外界对其预期的意外影响,即 「自由能」。

在人类中,这些需要最小化的目标体现为生理参数的自动调节,如体温、血氧和血糖水平等。这种机制确保了生物体对环境变化的适应性和生存能力。虽然类似的信息处理过程可以在计算机系统中模拟,但重要的区别在于,计算机并不真实地调节这些生理参数,而仅仅是模拟相关过程。意识也是如此。假设意识有助于有意识的有机体的生存,那么,根据自由能原理,有助于维持有机体的生理过程必须保留意识经验留下的痕迹,这可以描述为信息处理过程。这可以称为 「意识的计算相关性」。

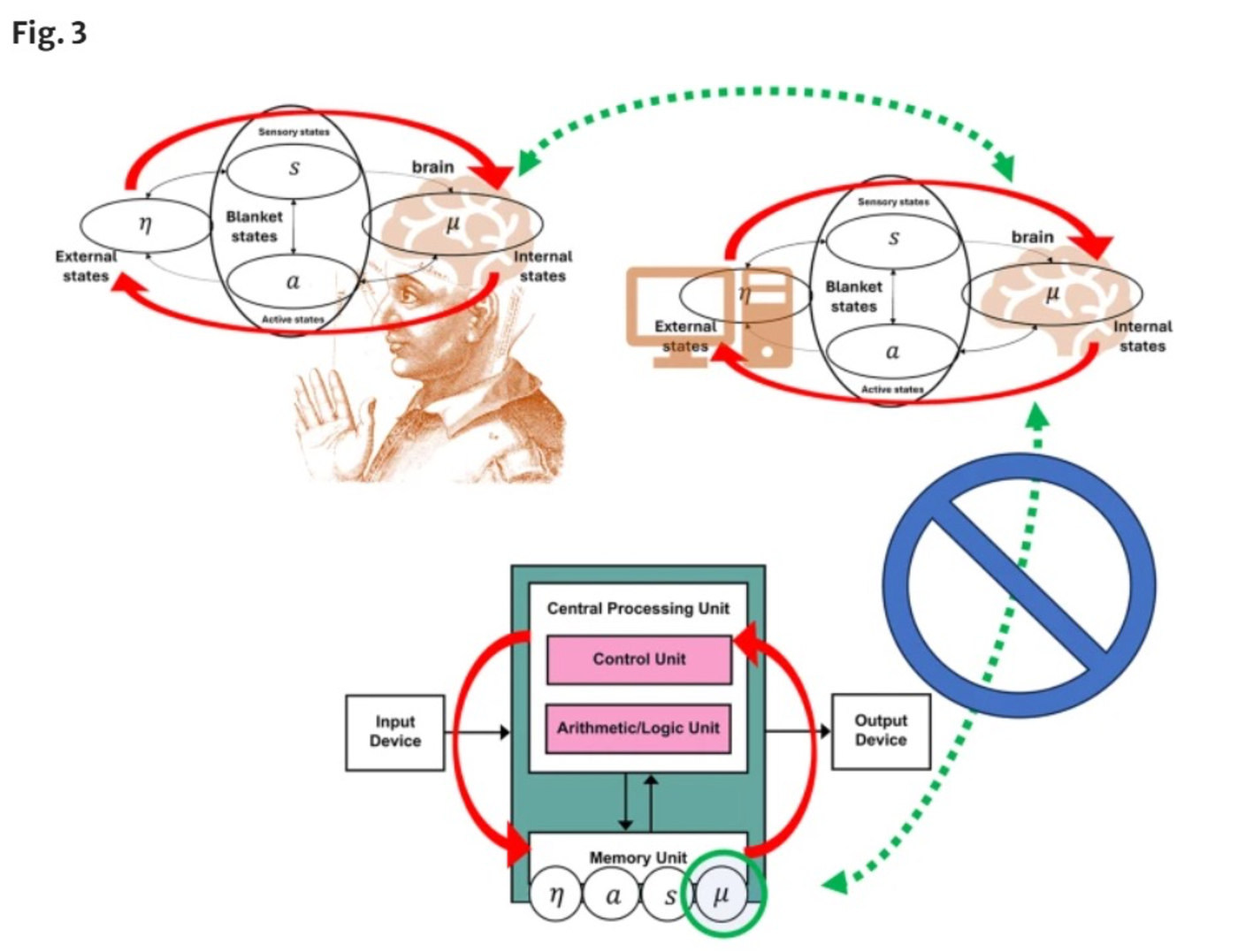

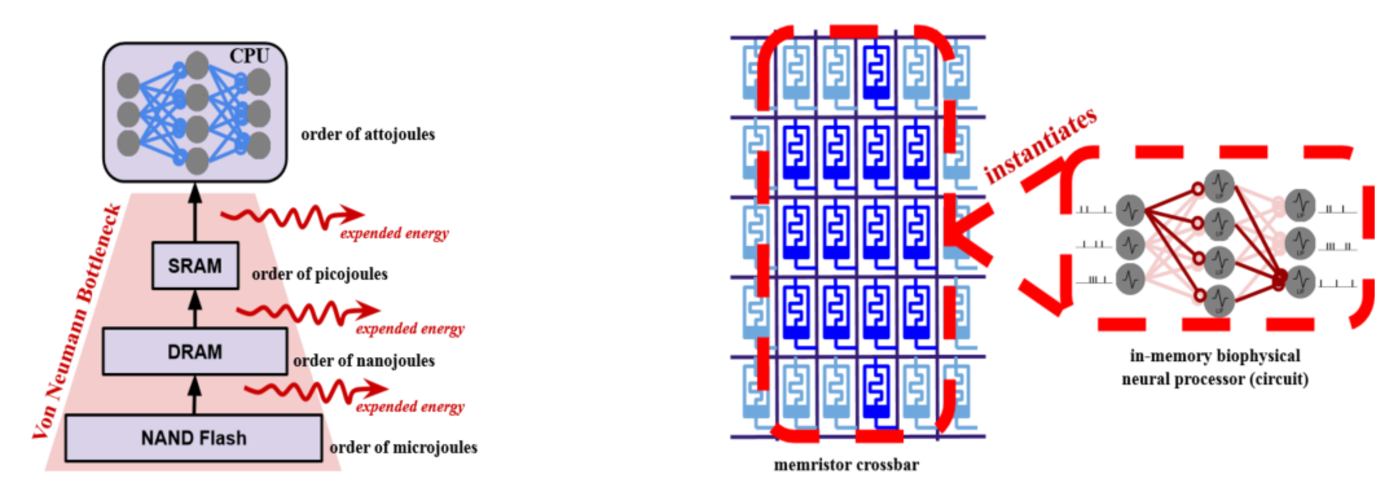

在传统计算机中,数据处理遵循一个线性的路径:数据必须首先从内存中加载,然后在中央处理单元中处理,最后再次存储在内存中。这种处理和存储的分离在大脑中是不存在的。大脑的不同区域间的因果联系直接且复杂,不需通过类似中央处理单元的独立结构进行中转。在自由能的视角下,这样的因果结构差异导致了生物脑产生的意识和传统电脑模拟的意识存在差异。

▷上图展示了右上角:一个具身化的大脑和外界的因果信息流,以及左上角,一个生活在模拟中的大脑的因果流,以及下图在传统电脑中的因果结构。来自:https://link.springer.com/article/10.1007/s11098-024-02182-y

从自由能原理的角度来看,生物体通过最小化意外 (自由能) 来保证自身的持续存在。而意识的出现则是为了捕捉这一过程中的因果关系。由于计算机和人脑所呈现的因果流不同,大脑和计算机之间的因果结构差异可能对意识至关重要。这决定了当前传统类型的计算机及其上所运行的人工智能系统不太可能具有意识。从自由能的视角出发,研究者可以更精确地探索和定义构成意识的先决条件,并分析在人工系统中实现类似生物意识功能的可能性和挑战。

凡人计算:更有可能的机器智能之路

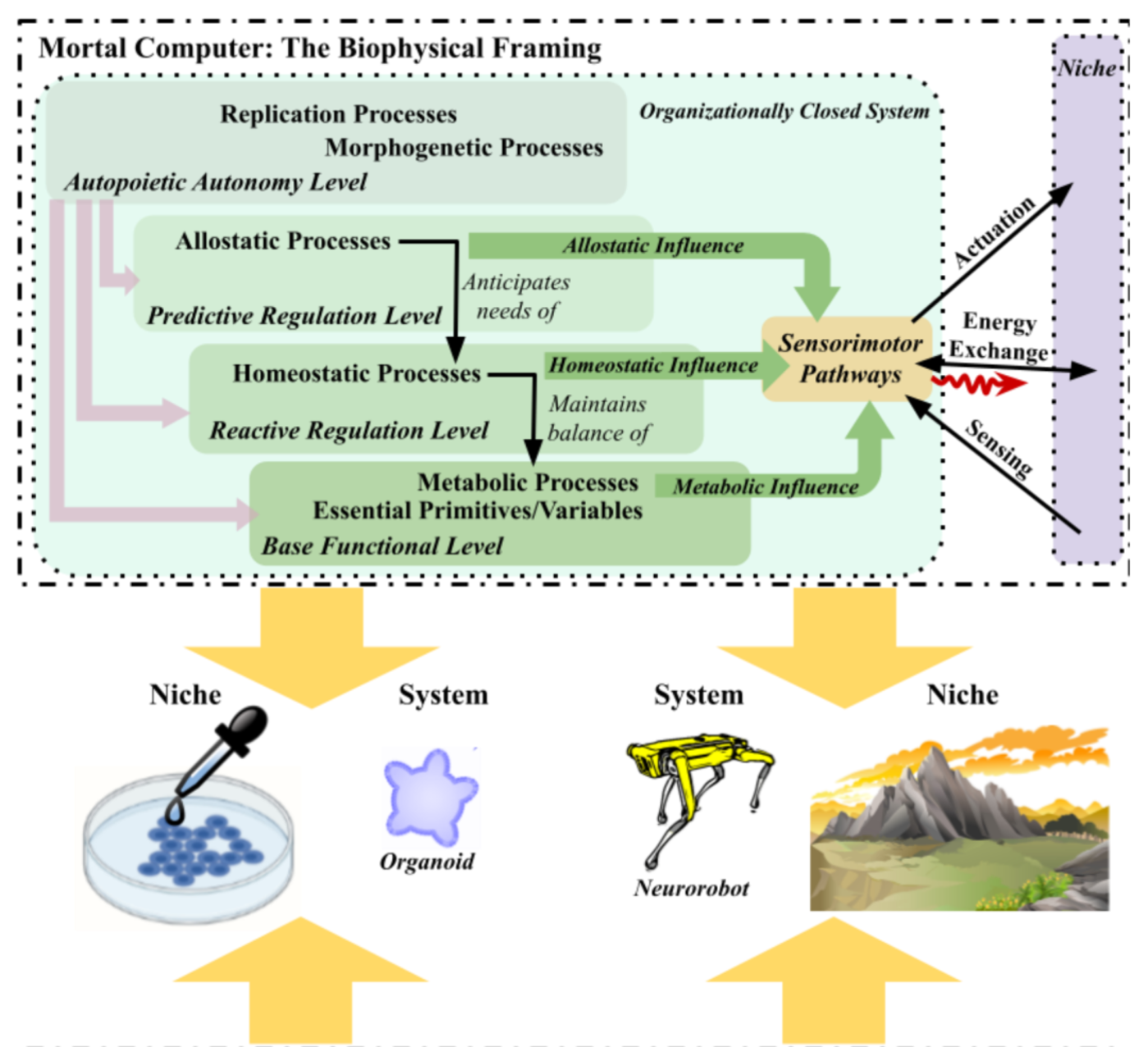

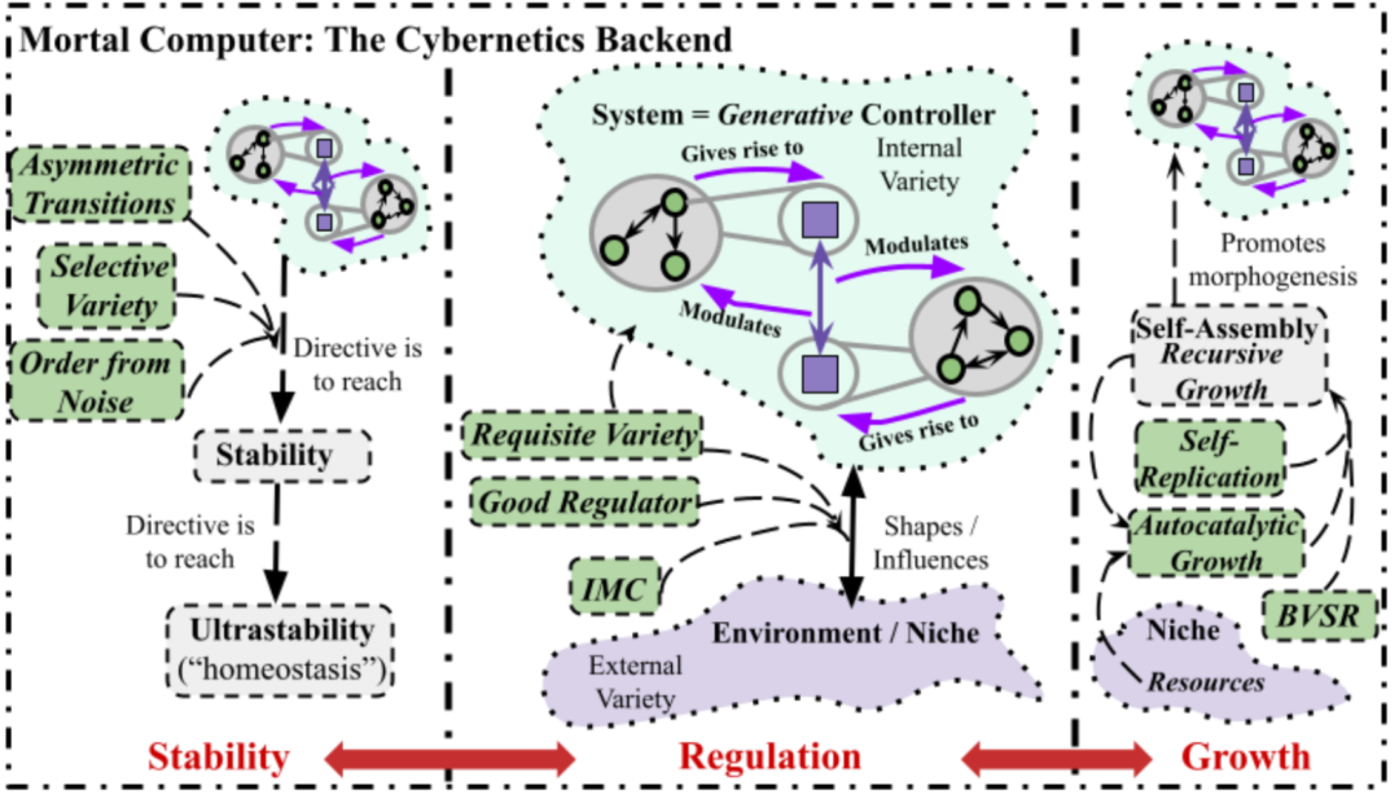

近年来,Hinton 提出的凡人计算 (Mortal Computation) 模型引发了对传统计算模式的深度反思。标准计算机科学的一个核心原则是软件应与硬件分离,这样在不同的硬件上执行相同的算法会得到相同的输出。例如一个神经网络可以在一台计算机上训练并获取权重,然后在另一台计算机上运行,它们会得到相同的过程与结果。这种模式突显了软件的 「不朽」 特性——软件不依赖于硬件,即使原始存储介质损坏,也可以通过更换硬件继续使用软件。

然而,凡人计算挑战了这一传统观念。它允许在执行相同任务的不同硬件上的神经网络之间发生显著且事先未知的变化,这些变化依赖于各自硬件的特性和学习过程,从而为每个硬件定制独特的软件配置。这种做法使得软件与其运行的硬件紧密绑定,一旦硬件损坏,相应的软件也会丧失,反映出生物大脑的易逝性计算特征——生物大脑的计算活动与其物理基础不可分割。

▷Hinton, Geoffrey. "The forward-forward algorithm: Some preliminary investigations." arXiv preprint arXiv:2212.13345 (2022).

凡人计算在硬件失效时会造成软件丢失,这表面上看似是资源的浪费,但实际上它揭示了传统计算模型中的一个重要缺陷:不朽的计算在能耗上昂贵。它需要进行持续的错误纠正,以确保存储中的 1 保持为 1,0 保持为 0。随着算法的复杂性增加,在深度神经网络支持的现代人工智能系统中,错误纠正的计算和能量成本迅速增长。

与此相对,生物大脑因其高效的能量使用,无法实现不朽的计算。因此生物执行的计算是 「易逝 「的,这意味着它们不能与实现它们的 「硬件」(或 「湿件」) 分离。这种特性使得意识与其物质基础的分离变得不太可能 (即生物自然主义假说)。因为当前无论哪种人工智能,都是基于一个计算不朽的实现范式,故而这是一个对当前技术范式下有意识的人工智能存在,特别有力的反对论据。

▷对比当下传统的冯诺伊曼架构的神经网络 (左图),以及神经形态计算 (以忆阻器交叉阵列实现的芯片,处理直接在内存内部进行) 实现的凡人计算 (右图),来自:https://arxiv.org/pdf/2311.09589v1

当然,对标准计算机科学范式的挑战已经存在很长时间了。神经形态计算的倡导者们主张开发更贴近生物神经网络的硬件,这种硬件与当前计算机中主导的 CPU 和 GPU 截然不同。研究者已经开发出使用尖峰在不同的硬件元素之间进行通信的神经形态芯片,可能提供相比传统芯片显著更高的能效。一些神经形态方法强调模拟而不是数字计算,将计算功能更直接地与硬件联系起来。相比冯诺伊曼范式,在生物自然主义的框架下,完全突破现有硬件约束的凡人计算,更有可能具有意识。

▷图 2: 生物物理视角的凡人计算设备:关注生物体与内部稳态的维持的自复制 (上图) 及控制论视角下的凡人计算设备 (下图) 来自:https://arxiv.org/pdf/2311.09589v1

机械姬中意识测试存在的问题

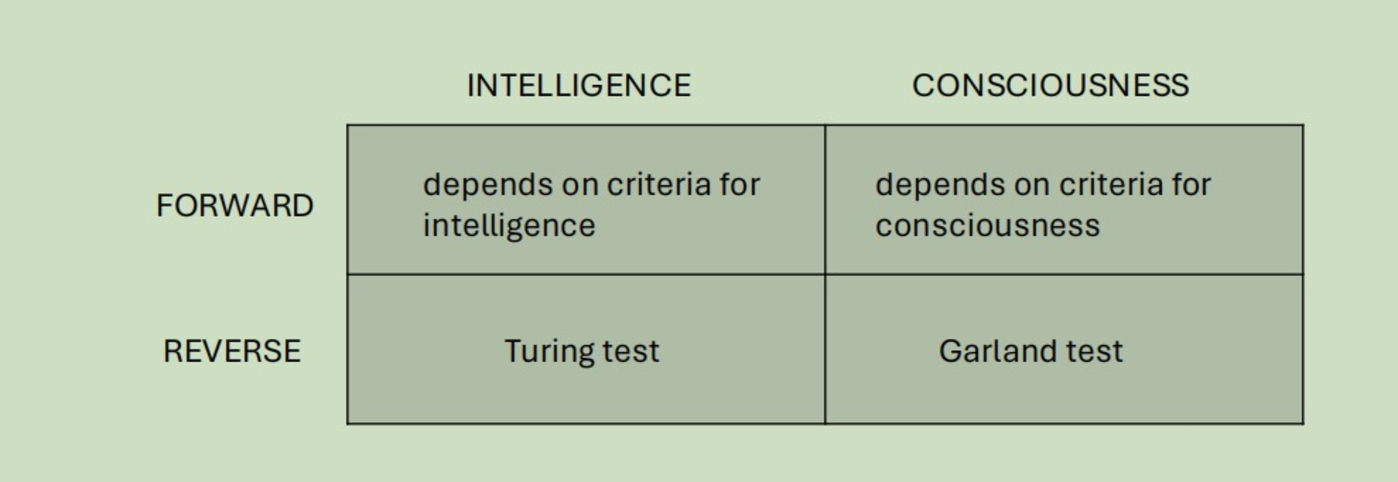

科幻电影 《机械姬》 提出了一个类似于图灵测试的 Garland 测试。两者都是从反向去考察机器能否具有意识,即让普通人尝试分辨,如果机器足够以假乱真,那么就算通过了测试。与之相对的是正向的测试,例如根据对智能,意识的不同定义方式构建的指标进行判断 (图 3)。

▷图 3:四种不同判断机器能否具有智能/意识的方式。

这种反向的考察带来了可能的批判:图灵测试究竟在检测机器的智能,还是人类的轻信程度?《机械姬》 中的对话指出,这种测试实际上可能更多地在评价测试者本身,而非被测试的 AI。此外,反向意识测试的一个关键问题是意识本身是一种主观体验,难以通过外部评价者客观判定。不过,建立正向的测试方式目前也很困难。正向测试依赖的指标取决于各自的理论框架,而我们当前尚且不确定解释意识应使用何种理论框架。

当大语言模型被引导进行关于 「意识」 的对话时,它们可以流畅地描述自己的意识本质,这让一些人误认为这些模型可能已具有某种形式的意识。这种现象很大程度上与媒体使用拟人化的语言描述大模型的行为有关。例如当大模型发布不实信息时,媒体可能将其描述为 「幻觉」,而更准确的描述应该是 「虚构」。在人类中,虚构通常是无意的创造性行为,而幻觉则涉及对感知体验的改变。因此,将大模型的行为描述为虚构而非幻觉,有助于避免错误地赋予它们任何意图或主观体验的属性。

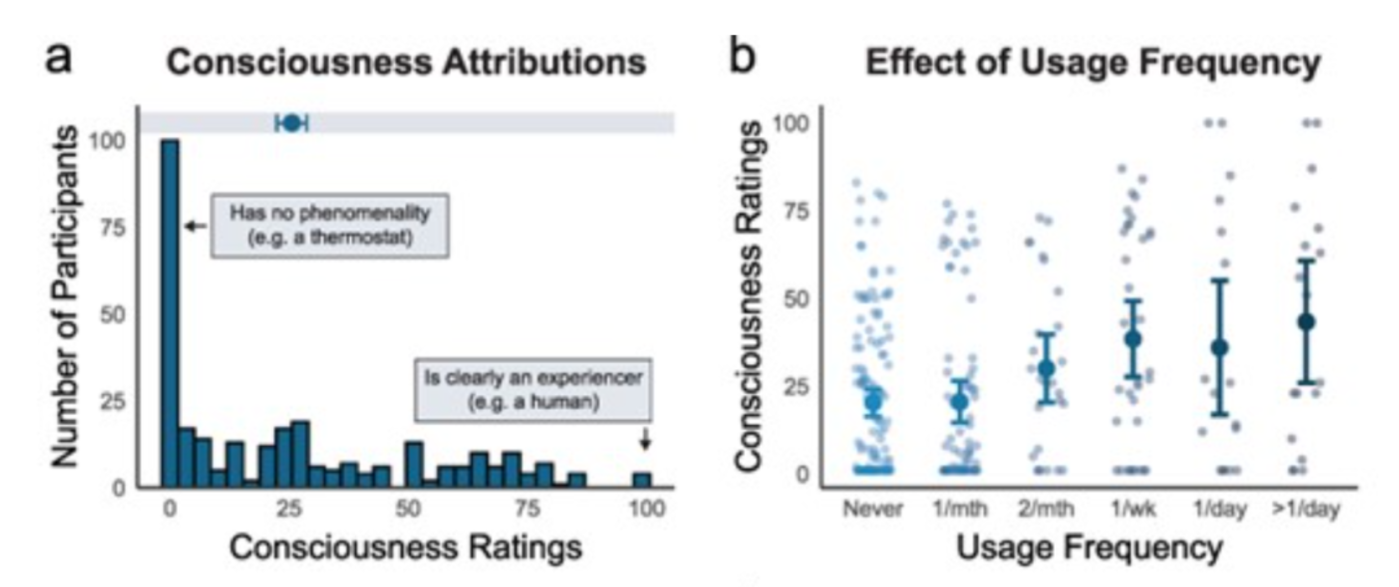

▷被试者对大模型是否具有意识的评分,以及不同使用频率者的评分差异,来自:https://academic.oup.com/nc/article/2024/1/niae013/7644104

当然,那些让大模型看起来有意识的对话还有更朴实的解释。大模型本质上是一种统计算法,预测最可能承接的下一个词。这些模型通过大量包含关于意识讨论的文本进行训练,因此能够在提及意识时生成流畅的回应。

为什么关于大模型是否有意识会有这么大的争议?看似能论证机器意识的大模型互动案例并不是直接原因。相反,案例中的这些对话利用了我们的偏见——包括人类中心主义和对机器的拟人化投射,以及对语言的误解,认为语言是思考的主要工具,而其实语言的主要功能是沟通。这些看似显示大模型具有意识的对话,实际上也引起了图灵测试和意识测试之间的混淆。这些对话被无缝地融入到了广泛流传的科幻叙事中,如电影 《机械姬》 所示,当机器能与我们交谈,尤其是关于意识的话题时,似乎就显示出了意识。然而,这些现象的更朴素的解释应该是大模型的训练数据和工作原理所决定的。

西部世界与 《弗兰肯斯坦》:机器意识争论带来的道德考量

虽然真正有意识的人工智能还难以实现,但 「类意识」AI 系统 (Conscious-seeming AI) 的到来几乎可以板上钉钉。这样的系统能够以假乱真,给人以 「有意识」 的错觉,而且可能已经存在。当足够令人信服的大语言模型与先进的生成式视频和音频化身 (长远看,甚至是具身机器人) 相结合时,我们将生活在一个与我们认为有意识的 AI 系统共享的世界中,无论事情的真相如何。

这种类意识 AI 引发了重大的道德伦理问题。它能够很好地利用人性的脆弱,无论这项脆弱是偶然的,还是 (企业) 设计的。例如,如果我们认为一个智能助理有意识,它真正理解我们、真正关心我们,我们可能会更倾向于盲目遵循它给出的建议,即使这些建议是错误的或有害的。如果我们感觉我们在与另一个心灵而不是算法打交道,我们可能也更愿意牺牲自己的数字隐私。

这种现象在 《西部世界》 中得到了艺术表现:我们知道某系统实际上并无意识,却仍可能感觉它好似具备意识。这种情况下,我们面临两难选择:一是选择关心这类系统,赋予其某种伦理地位,即便我们知道它们是无意识的;二是选择忽略这些系统,放弃我们的同情心。两种选择都有其问题:如果我们选择关心无意识的系统,可能会扭曲我们的道德关怀,将注意力从真正需要关心的对象 (如其他人类或非人类动物) 上转移;如果我们选择不关心,可能会使我们对他人的感受变得麻木。

这就是 《西部世界》 剧中发生的事情。如果我们以对待计算器的方式对待类意识智能体,那我们可能在现实中也会漠视他人的感受——这会抹杀我们的道德敏感性,也可能让我们自己也感到不快。实际上,已有很多人对对智能助手 Siri 的无礼行为感到内疚。

玛丽·雪莱的 《弗兰肯斯坦》 为我们提供了一个道德寓言,这部作品通常被视为对创造生命傲慢的警告。然而,弗兰肯斯坦真正普罗米修斯式的罪过并不是赋予他的创造物生命,而是赋予其意识。其创造物因此具备了痛苦、嫉妒和愤怒的能力,引发了恐怖和屠杀。在与类意识智能体互动时,我们不应重蹈覆辙。

类意识智能体的出现也不完全是坏事,它可能更容易让使用者与之互动,提高他们的效率并扩大智能体的可访问性。例如在个性化治疗等领域,类意识智能体能够让用户表现出更高的依存性。利弊得失取决于开发者和监管者的选择,正如丹尼尔·丹尼特曾说过的:「我们一生中只会看到工具级的智能,而非同事级的智能。不应将它们视为同事,也不应欺骗自己认为它们是同事。」

小结

让我们回顾一下可能出现有意识的 AI 的各种场景。

第一种:意识是一种计算形式,随着 AI 越来越智能,有意识的 AI 会在人类迈入通用人工智能的门槛时出现。该文指出:这一场景是基于我们的心理偏见,以及对计算功能主义未经充分检验的假设,因此不太可能。

第二种:意识是一种计算形式,但它必须根据意识理论被明确地 「设计」 到人工系统中。这看起来更有可能,但仍取决于 (1) 计算功能主义是否成立,(2) 相关理论是否能够真实指定意识存在的充分条件,以及 (3) 相关的计算是否可以在非碳基的物理基础中实现。基于如全局工作空间等意识理论,构建有意识的 AI 的尝试属于这个场景。尽管这个场景避免了将意识与智能混淆,但它仍建立在值得怀疑的计算功能主义成立这一假设上。

第三种:意识是基于计算的,但相关的计算——可能因为它们寿命有限——只能由特定类型的物理基础来实现。在这种场景中,传统冯诺依曼架构下的 AI 可能无法成为有意识 AI。有意识的 AI 将更接近生物意识系统。通过基于神经形态计算的凡人计算来实现有意识的 AI 就属于这个场景。

第四种:意识依赖于神经系统而非计算功能组织。这时计算功能主义将不再成立,模拟与意识相关的认知功能与结构将不足以实例化意识。在这种情况下,有意识的 AI 的可信度取决于神经系统中的非计算功能 (如动力学特征) 是否可以在硅基等其它物理基础中实现,例如构建足够真实的人工生命。这一场景被称为弱生物自然主义,其中只有生命系统可以实现意识所需的必要功能组织。

最后一种场景是强生物自然主义。意识依赖于生命系统的物质特性,就像风暴依赖于真实的水和真实的风一样。在这个观点中,有意识的 AI 需要 (在某种相关意义上) 是活着的,哪怕不是碳基。当然,正如水与风不一定引起风暴一样,有生命也不代表有意识。这里值得强调的是,即使生物自然主义 (弱或强) 是错误的,我们仍然可能需要通过理解我们作为生命体的本质,来理解人类和动物的意识,而不应该拿评价机器的指标来理解和考察意识。

意识要么是通过某些生物结构实现的,要么是通过某些功能/计算实现的,而意识要么是通过简单/低级现象实现的,要么是由复杂/高级现象实现的。如果意识与任何类型的功能正确地联系在一起,LLMs 可能已经接近于有意识,并且未来的发展可能会导致有意识的人工系统。如果意识实际上与生物结构相关联,那么复杂性方面就会有所不同。根据这种观点,我们的 LLMs 永远不会是有意识的,因为它们没有在 「正确」 的物理学基础中被实例化。

▷来自:https://www.nature.com/articles/s41599-024-03553-w

将大脑视为计算机,混淆智能(intelligence) 与意识(consciousness),这些思潮很可能让人们高估在不远的未来出现真正有意识的人工智能 (的可能性)。然而尽管人类中心主义和拟人化的偏见在推动这一趋势,但意识也不会随着 AI 变得更智能而自动到来。该文提出的证据 (意识与生命,以及更具体地说,与预测处理、自复制和代谢热力学的相互关系) 说明,在传统的冯诺依曼式的 AI 系统中,意识可能是生命系统的属性,且或许只可能是生命系统的属性。

当前,我们无法确定创造有意识 AI 所需的具体条件,也不清楚如何防止其出现。有意识的 AI 可能赋予系统源于自身需求的目标,而不仅仅是系统设计者预设的功能。这进一步复杂了智能体的 「价值对齐问题」,即如何确保 AI 行为符合人类利益和价值。

因此,追求有意识的 AI 不应该是 AI 研究的明确目标。这可能听起来显而易见,但令人惊讶的是,「有意识的 AI」 在 AI 研究中经常被当作一个圣杯。实际上,随着技术的发展和我们对生物意识理解的加深,我们应该不断调整对意识存在的信念,并使用这些不断演变的信念引导 AI 的发展。真正有意识的人工智能在当前轨迹上可能无法实现,这意味着我们不应该盲目追求它,以服务于一些未经深思熟虑的技术狂热。

虽然本文倾向于某种形式的生物自然主义,但要可靠的评估前文列出几种场景的可信度是非常困难的。逐个列出这些假设,可以提醒我们有意识的 AI 并非不可避免,同时也突显了理解控制生物意识的神经科学机制的重要性和紧迫性。

作为人类,我们习惯根据自己的形象创造技术,并将自我投射到我们创造的技术中。由意识与 AI 之间关系的概念迷雾所造成的混淆,阻碍了我们清晰地看到类意识智能体这一技术所代表的风险和机遇。将智能混淆为意识更阻止了我们清晰地认识自身——我们作为活生生的、呼吸着的、感受着的、行动着的和思考着的生物。如果我们把人类体验与由深度伪造技术增强的语言模型中的信息处理机器混淆起来,那么我们就廉价地出卖了自己,也贬低了人的本质。