(图片来源:AI 生成的图像)

北京时间 8 月 16 日,饱受争议的美国加州 《前沿 AI 模型安全创新法案》(后称加州 AI 安全法案 SB 1047) 在大幅度削弱相关条款之后,最终顺利通过加州众议院拨款委员会的审核。

加州参议员维纳团队向 TechCrunch 表示,该法案增加了 AI 公司 Anthropic 和其他反对者提出的几项修正案,最终在加州拨款委员会获得通过,朝着成为法律迈出了重要一步,其中进行了几项关键修改。

“ 我们接受了提议的一系列非常合理的修正案,我相信我们已经解决了 Anthropic 和业内许多其他人表达的核心担忧,” 维纳参议员在声明中表示。“ 这些修正案建立在我之前对 SB 1047 做出的重大修改的基础上,以适应开源社区的独特需求,而开源社区是创新的重要源泉。”

SB 1047 仍旨在通过追究开发者的责任来防止大型 AI 系统造成大量人员死亡或造成损失超过 5 亿美元的网络安全事件。然而,该法案现在赋予加州政府更少的追究 AI 实验室责任的权力。而在国家层面监管法律难产的困局中,这成为了美国在 AI 监管上迈出的重要一步。

但是,李飞飞、杨立昆等 AI 行业部分人士认为,这最终将会损害加州乃至美国在 AI 领域的领先地位。数百名创业者签署了孵化器 YC 撰写的反对信,加州的 100 多位学界人士也发文反对,风投机构 a16z 专门建立网站细数法案六宗罪。目前,美国各地都在讨论许多 AI 法案,但加州的 《前沿人工智能模型安全创新法案》 已成为最具争议的法案之一。

对国内企业来说,法案要求云服务提供商收集客户信息、IP 地址、支付方式等信息,这便利了监管部门的溯源工作。若后续管制进一步收紧,这可能会成为部分使用海外算力进行训练的中国 AI 企业面临的监管风险。

那么如今,加州 AI 法案获得通过,对于中美 AI 行业影响几何?钛媒体 AGI 梳理六个问题和回答,解释这一法案和背后一些信息。

一、加州 AI 法案有哪些新的约束?主要起什么作用?

加州 AI 法案 SB 1047 试图防止大型 AI 模型被用于对人类造成“ 严重伤害”。

该法案列举了“ 严重危害” 的例子。例如,不良行为者使用 AI 模型制造武器,造成大量人员伤亡,或指示 AI 模型策划网络攻击,造成超过 5 亿美元的损失 (相比之下,CrowdStrike 中断估计造成的损失超过 50 亿美元)。该法案要求开发者 (即开发模型的公司) 实施足够的安全协议,以防止此类后果。

SB 1047 的规则只适用于世界上最大的 AI 模型:成本至少为 1 亿美元,训练期间使用 10^26 FLOPS 的模型—— 这是巨大的计算量,但 OpenAI 首席执行官 Sam Altman 表示,GPT-4 的训练成本大约是这么多。这些门槛可以根据需要提高。

目前,很少有公司开发出足够大的公共 AI 产品来满足这些要求,但 OpenAI、谷歌和微软等科技巨头可能很快就会这样做。AI 模型 (本质上是识别和预测数据模式的大型统计引擎) 通常随着规模的扩大而变得更加准确,许多人预计这一趋势将持续下去。马克· 扎克伯格最近表示,下一代 Meta 的 Llama 将需要 10 倍以上的计算能力,这将使其受到 SB 1047 的管辖。

最值得注意的是,该法案不再允许加州总检察长在灾难事件发生前起诉 AI 智能公司疏忽安全措施。这是 Anthropic 提出的建议。

相反,加州总检察长可以寻求禁令救济,要求公司停止其认为危险的某项操作,并且如果 AI 模型确实导致了灾难性事件,加州总检察长仍然可以起诉 AI 开发商。

二、谁来执行法案?如何执行?

目前新的加州 AI 法案已经宣布,不再设立前沿模型部门 (FMD) 机构。但是,该法案仍然设立了前沿模型委员会——FMD 的核心—— 并将其置于现有的政府运营机构内。事实上,该委员会现在规模更大,有 9 人而不是 5 人。前沿模型委员会仍将为涵盖的模型设定计算阈值,发布安全指南并为审计人员发布法规。

修正后的法案最大的调整是,不再允许加州总检察长在灾难性事件发生前起诉 AI 企业忽视安全问题的行为。原有法案规定,只要审计员发现 AI 企业在日常运营中存在违法行为,企业就有可能被起诉。这标志着法案的监管重点转变为实际危害,也将减轻企业的合规压力。

最后,该法案还规定,如果模型公司内部员工试图向加州总检察长披露有关不安全的 AI 模型的信息,则将为员工提供举报人保护。

多数美国科技企业和 AI 创企都在加州运营,将受该法案约束。具体来看,这一法案主要关注“ 前沿 AI 模型”,只有训练模型算力成本超 1 亿美元的开发商才会面临监管要求,现有模型均不在监管范围内。未来 Llama 4 和 GPT-5 或许会是其主要监管对象。

三、违法行为如何惩罚?罚款 1000 万美元起,可判决关闭或删除模型

法案显示,模型开发公司的首席技术官必须向 FMD 提交年度认证,评估其 AI 模型的潜在风险、其安全协议的有效性以及公司如何遵守 SB 1047 的描述。与违规通知类似,如果发生“AI 安全事件”,开发商必须在了解事件后 72 小时内向 FMD 报告。

如果开发者未能遵守任何这些规定,SB 1047 允许加州总检察长对开发者提起民事诉讼。对于一个花费 1 亿美元训练的模型,第一次违规的罚款可能高达 1000 万美元,后续违规的罚款高达 3000 万美元。随着 AI 模型变得越来越昂贵,罚款率也会随之增加。

一旦出现违法行为,企业可能面临 1000 万-3000 万美元不等的罚款,这一金额还将随着模型训练成本的增加水涨船高。

另外,若模型开发商和计算集群运营者无法遵守上述规定,并造成巨大危害,若判定确实存在违法行为,法院可能会判处下类处罚:

1、针对 2026 年及之后的违法行为,首次违法的实体将被处以云计算市场训练范围内模型平均成本 10% 以内的罚款,对于后续违法行为,罚款金额不超过这一成本的 30%(按法案中对范围内模型定义的 1 亿美元门槛计算,首次违法的罚款至少为 1000 万美元)。

2、法院还可宣布采取禁令,包括但不限于修改、全面关闭或删除范围内模型及其开发商所控制的所有衍生品。

不过,修改、关闭和删除范围内模型的处罚,仅在其造成他人死亡、严重人身伤害、财产损失或严重的公共安全威胁时才可使用。

四、谁在反对法案?为何反对?

尽管该法案遭到了美国国会议员、知名 AI 研究人员、大型科技公司和风险投资家的强烈反对,但它还是相对轻松地在加州立法机构获得了通过。这些修正案可能会安抚 SB 1047 的反对者,并为州长纽森提供一份争议较少的法案,他可以在不失去 AI 行业支持的情况下签署成为法律。

如今,越来越多的科技人士反对加州 AI 法案。

Anthropic 方面表示,它正在审查 SB 1047 的变更,然后再做出决定。此前该公司的修订建议并非全部都被维纳参议员采纳。

知名风投机构 a16z 则在官网列出他们眼中加州 AI 安全法案的“6 宗罪”:

- 该法案将对加州的 AI 投资和发展带来寒蝉效应。

- 该法案依照并不明确的结果对开发者/开发商进行处罚。相关测试尚不存在。

- 该法案模糊的定义加上严格的法律责任,给 AI 开发商和企业主带来了巨大的不确定性和经济风险。

- 该法案可能迫使 AI 研究转入地下,无意中降低 AI 系统的安全性。

- 该法案对开源和初创企业开发者们造成了系统性的不利,而他们是加州创新和小微企业的核心。

- 该法案抑制了美国的 AI 研究与创新,给中国等国家在 AI 方面超过美国提供了机会。

a16z 创始合伙人安德里森· 霍洛维茨 (Andreessen Horowitz) 认为,加州 AI 法案虽出于好意,但因误导可能会削弱美国科技产业,正当技术未来正处于关键十字路口之时。美国需要领导者认识到,现在是采取明智且统一的 AI 监管行动的关键时刻。

斯坦福大学教授李飞飞则在 《财富》 杂志网站上发文详细解释反对理由,认为这一法案的主要问题有 4 点:过度惩罚开发者,因此有可能扼杀创新;“ 终止开关” 将束缚开源开发工作,摧毁开源社区;削弱学术界和公共部门的 AI 研究,还有可能阻碍学术界获得更多资金;并未解决 AI 进步带来的潜在危害,如偏见或深度伪造问题。

此外,YC 孵化器支持的数百家创企联名认为,这一法案可能会对行业和开发者生态带来四个负面影响:

- 法案应惩罚滥用工具者,而非开发者。开发者往往难以预测模型的可能应用,伪证罪的设定让开发者可能因此入狱。

- 监管门槛无法充分捕捉技术发展的动态。非加州公司将能更自由地发展 AI 技术,这可能影响加州的创新。

- “Kill Switch(指开发商关闭模型的能力)” 可能会禁止开源 AI 的开发,抑制了开源的协作性和透明度。

- 法案的表述较为模糊,很可能被法官随意解释。

Meta 首席科学家、2018 年图灵奖得主杨立昆 (Yann LeCun) 也反对这一法案,他担忧如果未能准确评估范围内模型的风险,其中的连带责任条款已经表明,开源平台可能需要承担责任。

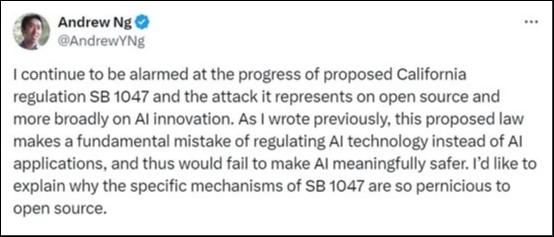

斯坦福大学计算机科学系和电气工程系的客座教授吴恩达 (Andrew Ng) 发文指出,美国加州 SB-1047 法案将扼杀开源大模型发展。法案应该监管的是 AI 应用程序而不是大模型本身。

他仍然认为美国加州拟定的 SB 1047 法案对开源大模型带来的巨大伤害感到震惊。这个法案犯了一个严重根本性错误,应该监管的是通过大模型开发的生成式 AI 产品,而不是开源大模型本身。

吴恩达还认为,SB 1047 法案要求开发人员保护开源大模型的乱用、修改以及开发非法的衍生成式 AI 产品。但开发人员应该如何保护、如何界定这些行为还非常模糊,没有一个详细的条例。

所以,吴恩达强烈呼吁大家来抵制 SB 1047 法案,他认为真的要是通过了将会对开源大模型的创新带来毁灭性打击,同时加州也会失去 AI 创新的动力。

五、谁在支持法案?为何要支持?

相对于反对声音,目前也有部分科技人士对于加州 AI 法案持有支持意见的。

其中,虽然加州州长纽森尚未公开评论 SB 1047,但他此前曾表示致力于加州的 AI 创新。

同时,图灵奖得主、“AI 教父” 杰弗里· 辛顿 (Geoffrey Hinton),图灵奖得主约书亚· 本吉奥 (Yoshua Bengio),哈佛大学法学院教授劳伦斯· 莱西格 (Lawrence Lessig) 和广受欢迎的 AI 教科书 《人工智能:现代方法》 作者、加州大学伯克利分校教授斯图亚特· 拉塞尔 (Stuart Russell) 联名写信给加州立法机构,表达他们对加州 AI 安全法案的“ 强力支持”。

这 4 位学者指出,他们对 AI 风险深感担忧,而加州的 AI 安全法案是有效监管该技术的最低要求。“ 法案没有许可证制度,不要求公司在培训或部署模型之前获得政府机构的许可。它依赖于公司对风险的自我评估,甚至在发生灾难时也不要求公司承担严格的责任。相对于我们面临的风险,这是一项非常宽松的立法。目前监管 AI 的法律还没有监管三明治店的严格,取消该法案的基本性措施将是一个历史性的错误——1 年后,当下一代更为强大的 AI 系统发布时,这一错误将变得更加明显。”

“ 四十年前,当我在训练 ChatGPT 等工具背后的第一版 AI 算法时,包括我自己在内,没有人会预测到 AI 会取得如此大的进步。强大的 AI 系统带来了令人难以置信的希望,但风险也非常真实,应该非常认真地对待。SB 1047 采取了一种非常明智的方法来平衡这些担忧。我仍然对 AI 通过改进科学和医学来拯救生命的潜力充满热情,但我们必须制定真正有力的立法来应对风险。加州是这项技术的起点,因为它是这项技术的起飞之地。” 辛顿表示。

四位学者还在信中强调,不论这些风险是杞人忧天还是真实存在,相关方都有必要承担减轻风险的责任。而“ 作为最了解这些系统的一群专家”,他们认为这些风险是可能存在并且足够重大的,我们有必要对此进行安全测试和常识性的预防措施。

加州参议员斯科特· 维纳 (Scott Wiener) 是该法案的起草人,他表示,SB 1047 旨在吸取过去社交媒体和数据隐私政策失败的教训,在为时已晚之前保护公民的安全。

“ 我们对待科技的态度是,等待危害发生,然后束手无策,” 维纳说。“ 我们不要等着坏事发生。我们要抢在它之前采取行动。”

- 开发者不会因无法预测模型风险而入狱。首先,初创企业开发者和学界不必担心,因为法案不适用于他们。其次,法案中的伪证罪条款仅仅在开发者“ 故意” 做出虚假陈述时才会生效,对模型能力无心的错误评判不会触发伪证罪条款 (该条款已在今天修正案中被删除)。

- 法案并未带来全新的责任。在现有的法律下,如果模型造成伤害,模型开发商和个人开发者都有可能被起诉,并且适用于所有能力的模型,所有受伤害的个体都可起诉。加州的新法案不仅限制了监管范围,还将起诉的权利限制在加州总检察长和劳工委员会两个实体上。

- 法案不会扼杀加州创新。该法案适用于所有在加州开展业务的企业,即便他们将总部挪出加州,也应该遵守相关规定 (智东西注:加州按 GDP 计算是世界第 5 大经济体,具备完整的科技生态,科技企业很难与加州脱钩)。当加州通过数据隐私法、环境保护法时,有许多人宣称这将阻碍创新,但事实是加州目前仍然在引领创新。

- 终止开关与安全评估要求不会阻碍开源 AI 的开发。法案目前已经修改并加强了对开源 AI 的保护。法案中对模型紧急停机的要求仅仅适用于开发人员控制范围内的模型,不包括不受控制的开源模型。法案还建立了一个新的咨询委员会,以倡导和支持安全可靠的开源 AI 开发工作。

根据法案,即使一家公司在德克萨斯州或法国训练了价值 1 亿美元的模型,只要它在加利福尼亚州开展业务,它就会受到 SB 1047 的保护。维纳表示,国会“ 在过去 25 年里几乎没有制定任何有关技术的立法”,因此他认为加利福尼亚州应该在这里开创先例。

人工智能安全中心主任 Dan Hendrycks 表示:“ 这一法案符合加州乃至美国产业的长期利益,因为重大安全事故可能是进一步发展的最大障碍。”

多名 OpenAI 前员工也支持这一法案,包括主动放弃 OpenAI 期权从而换取自由批评 OpenAI 公司权利的丹尼尔· 科科塔约洛 (Daniel Kokotajlo)。他认为,法案批评者称 AI 进步会停滞的说法大概率不会发生。

估值百亿美金的 AI 独角兽 Notion 创始人西蒙· 拉斯特 (Simon Last) 撰文称,他支持法案,认为在联邦级 AI 法律难产的情况下,加州作为全美乃至全球的科技中心,背负着重要的责任。他认为对模型的监管,在提升其安全性的同时也便利了在基础模型上构建产品的 AI 创企,这将减轻中小企业的负担。

人工智能安全行动基金中心高级政策顾问 Nathan Calvin 表示:“SB 1047 的目标是—— 并且一直是—— 提高 AI 安全性,同时仍允许整个生态系统进行创新。新的修正案将支持这一目标。”

六、下一步如何发展?

SB 1047 法案现在将提交加州议会进行最终表决。如果该法案在议会获得通过,由于最新的修正案,该法案将需要交回加州参议院进行表决。如果该法案同时获得通过,它将被提交到加州州长纽森的办公桌上,他将在 8 月底之前最终决定是否签署该法案。

维纳表示,他尚未与纽森谈过该法案,也不知道他的立场。

(本文首发于钛媒体 App,作者|林志佳,编辑|胡润峰)

更多精彩内容,关注钛媒体微信号 (ID:taimeiti),或者下载钛媒体 App