【TechWeb】7 月 10 日消息,奇富科技智能语音团队论文 《Qifusion-Net:基于特征融合的流式/非流式端到端语音识别框架》(Qifusion-Net: Layer-adapted Stream/Non-stream Model for End-to-End Multi-Accent Speech Recognition) 被全球语音与声学顶级会议 INTERSPEECH 2024 收录。

这是继去年奇富科技团队 《Eden-TTS:一种简单高效的非自回归 「端到端可微分」 神经网络的语音合成架构》 论文之后的又一篇论文被该国际顶会认可。

资料显示,INTERSPEECH 由国际语音通讯协会 (International Speech Communication Association, ISCA) 创办,是语音处理领域的顶级旗舰国际会议。作为全球最大的综合性语音处理领域的科技盛会,历届 INTERSPEECH 会议都备受全球各地语音语言领域人士的广泛关注。

此次被收录的奇富科技智能语音团队论文中 Qifusion 框架模型具有以下特点:

1. 方言种类更丰富:

凭借自身在贷后场景及方言领域的丰富数据样本,Qifusion 框架模型在原有东北官话、胶辽官话、北京官话、冀鲁官话、中原官话、江淮官话、兰银官话和西南官话等国内八种主流方言的基础上,精准强化了四川、重庆、山东、河南、贵州、广东、吉林、辽宁、黑龙江等用户密集地区的方言识别能力。这使得平均识别准确率相对提升了 25%,尤其在川渝地区,方言识别准确率相对提升超 35%。

2. 方言识别更精准:

Qifusion 框架模型具备自动识别不同口音的能力,并能在时间维度上对解码结果进行口音信息修正,使方言口音的语音识别误差率降低了 30% 以上,整体语音识别字错率降低了 16% 以上,显著提升了用户体验。此外,在业内知名的 Kespeech 开源方言数据集性能对比测试中,Qifusion 字错率刷新模型最低值,达到国内顶尖水平。

3. 方言识别更高效:

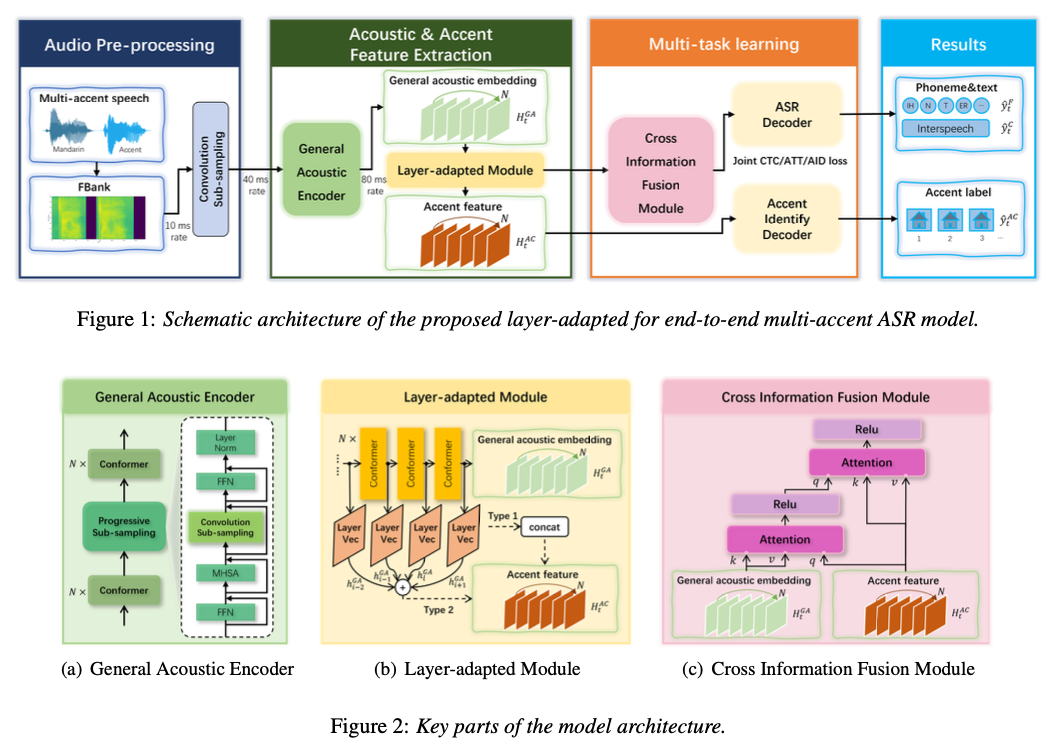

Qifusion 框架采用了创新的层自适应融合结构,能通过共享信息编码模块,更高效的提取方言信息。同时,该框架模型还支持即说即译功能,能在无需知晓额外方言信息的前提下,对不同方言口音的音频进行实时解码,实现精准的识别和转译。这使得 Qifusion 框架在业务场景中能够迅速准确地捕捉并响应用户需求。

据悉,奇富科技智能语音团队将受邀参与 9 月 INTERSPEECH 2024 科技盛会并发表主题报告,进一步分享其在语音识别领域的创新成果,与全球同行共探语音科技的未来。